rédigé par : Augustin Godon

pays

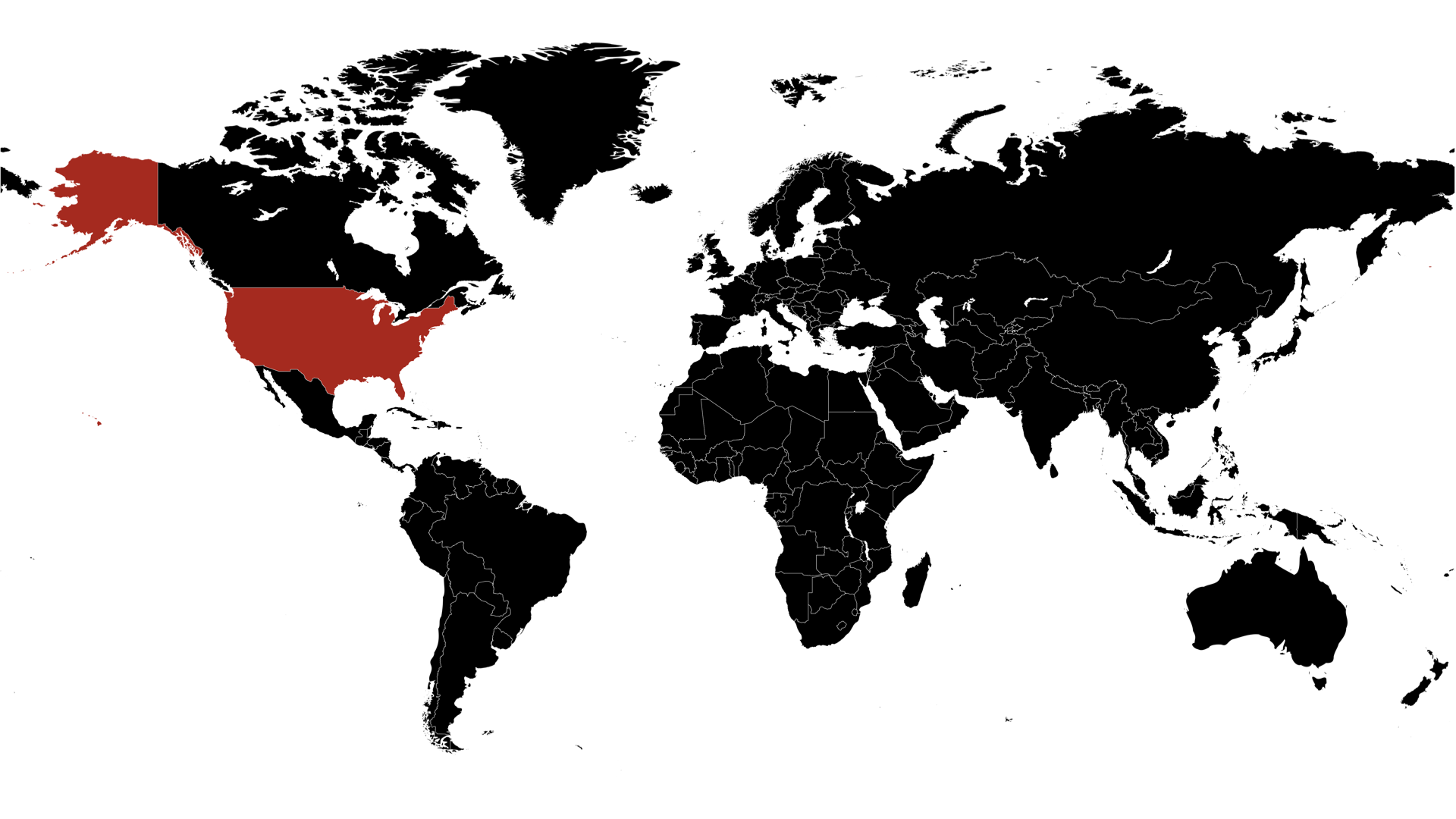

États-Unis

L'histoire des États-Unis, racontée à travers le prisme du cinéma, offre une perspective fascinante sur l'évolution du pays, ses valeurs, et ses luttes. Le cinéma américain, depuis ses débuts, a souvent reflété les changements sociaux, politiques et culturels de la nation. Voici un aperçu de cette histoire, vue à travers les films emblématiques de chaque époque.

Les débuts du cinéma (1890s-1920s)

Le cinéma américain commence à la fin du 19ème siècle avec des pionniers comme Thomas Edison et les frères Lumière. Les premiers films étaient de courtes séquences documentaires, souvent montrant des scènes de la vie quotidienne. À mesure que la technologie avançait, les films narratifs ont émergé, avec des réalisateurs comme D.W. Griffith. Son film "The Birth of a Nation" (1915), bien que controversé pour sa représentation raciste de la guerre civile et de la Reconstruction, a démontré le pouvoir du cinéma en tant qu'outil de storytelling ...

Un brin d'histoire...

Les États-Unis, fondés en 1776, ont évolué rapidement d'une collection de colonies britanniques à une superpuissance mondiale. Au 19ème siècle, le pays a connu une expansion territoriale rapide, marquée par des conflits tels que la guerre civile (1861-1865), qui a aboli l'esclavage. Le 20ème siècle a vu l'industrialisation, la participation aux deux guerres mondiales, et la lutte pour les droits civiques, transformant les États-Unis en une société plus égalitaire. La guerre froide a positionné les États-Unis comme un leader contre le communisme, tandis que la fin du siècle a marqué l'essor des technologies de l'information. Aujourd'hui, les États-Unis restent une nation influente sur le plan économique, culturel et militaire, confrontée à des défis internes et globaux complexes.